模型上下文协议(MCP)快速入门

随着 AI 技术的飞速,大语言模型的推理和质量都得到了快速提升。然而,即便是使用如此强大的模型可能也因为无法接触到数据而受到限制,被信息孤岛和遗留系统所困。同时每新增一个数据源,都需要定制的实现方式,使得真正互联互通的系统难以大规模拓展。MCP 正是为了解决这一挑战。它为将 AI 系统与数据源连接提供了一个通用、开放的标准,用一个协议替代了碎片化的集成方式,从而以更简洁、更可靠的方法,为 AI 系统提供所需的数据访问。

MCP推出的背景

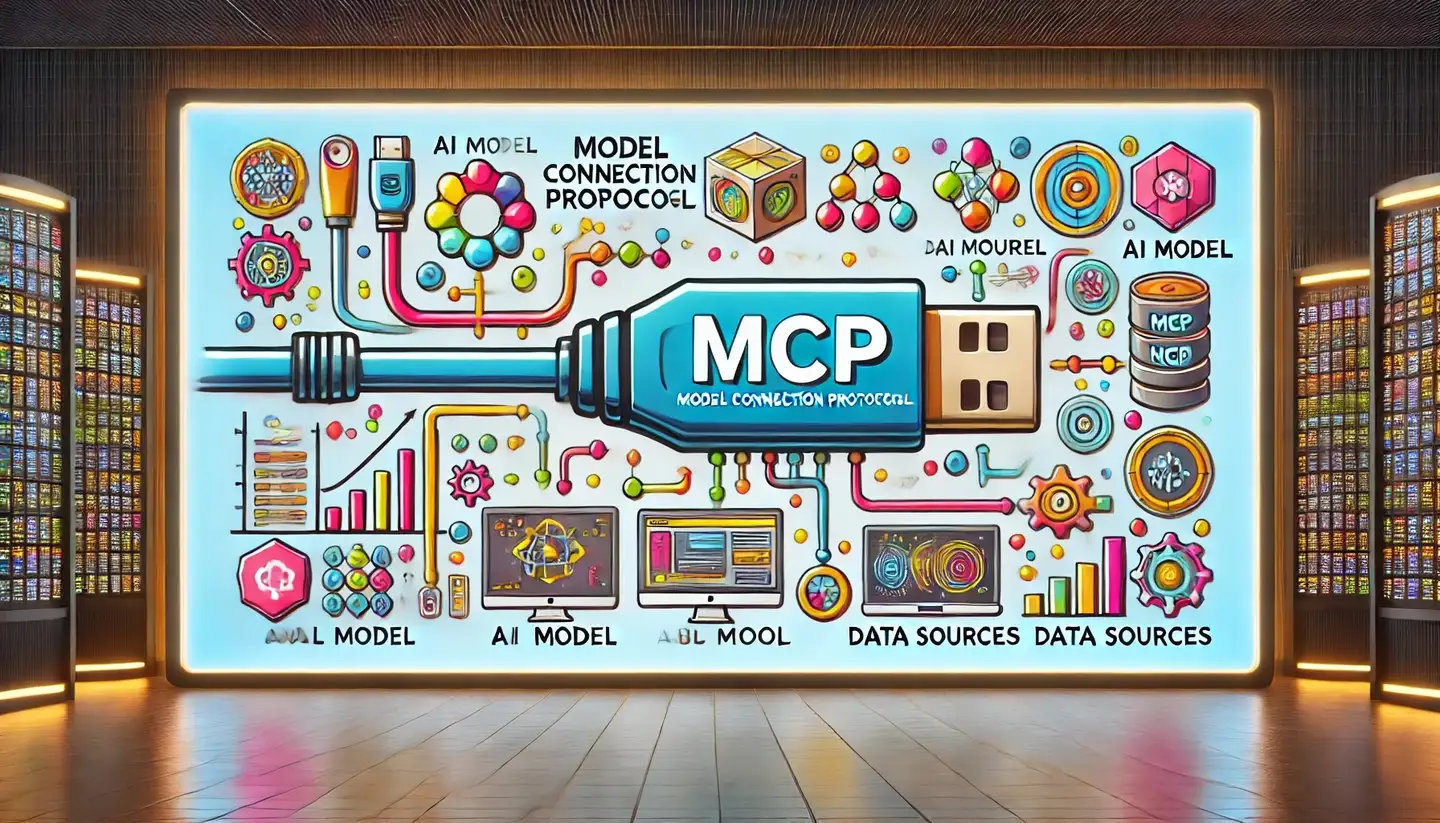

随着 AI 技术的飞速,大语言模型的推理和质量都得到了快速提升。然而,即便是使用如此强大的模型可能也因为无法接触到数据而受到限制,被信息孤岛和遗留系统所困。同时每新增一个数据源,都需要定制的实现方式,使得真正互联互通的系统难以大规模拓展。

MCP 正是为了解决这一挑战。它为将 AI 系统与数据源连接提供了一个通用、开放的标准,用一个协议替代了碎片化的集成方式,从而以更简洁、更可靠的方法,为 AI 系统提供所需的数据访问。

什么是MCP ?

MCP 是一种开放协议,用于标准化应用程序如何为大语言模型提供上下文。

可以将 MCP 比作 AI 应用的 USB-C 接口。就像 USB-C 提供了连接各类外设和配件的标准方式,MCP 提供了连接 AI 模型与不同数据源和工具的标准方式。

为什么选择 MCP?

MCP 帮助您基于 LLM 构建智能代理和复杂工作流。LLM 通常需要集成数据和工具,而 MCP 提供:

- 一个持续增长的预构建集成,使您的 LLM 可以直接连接

- 在不同 LLM 提供商和供应商之间切换的灵活性

- 在您的基础设施内保护数据的最佳实践

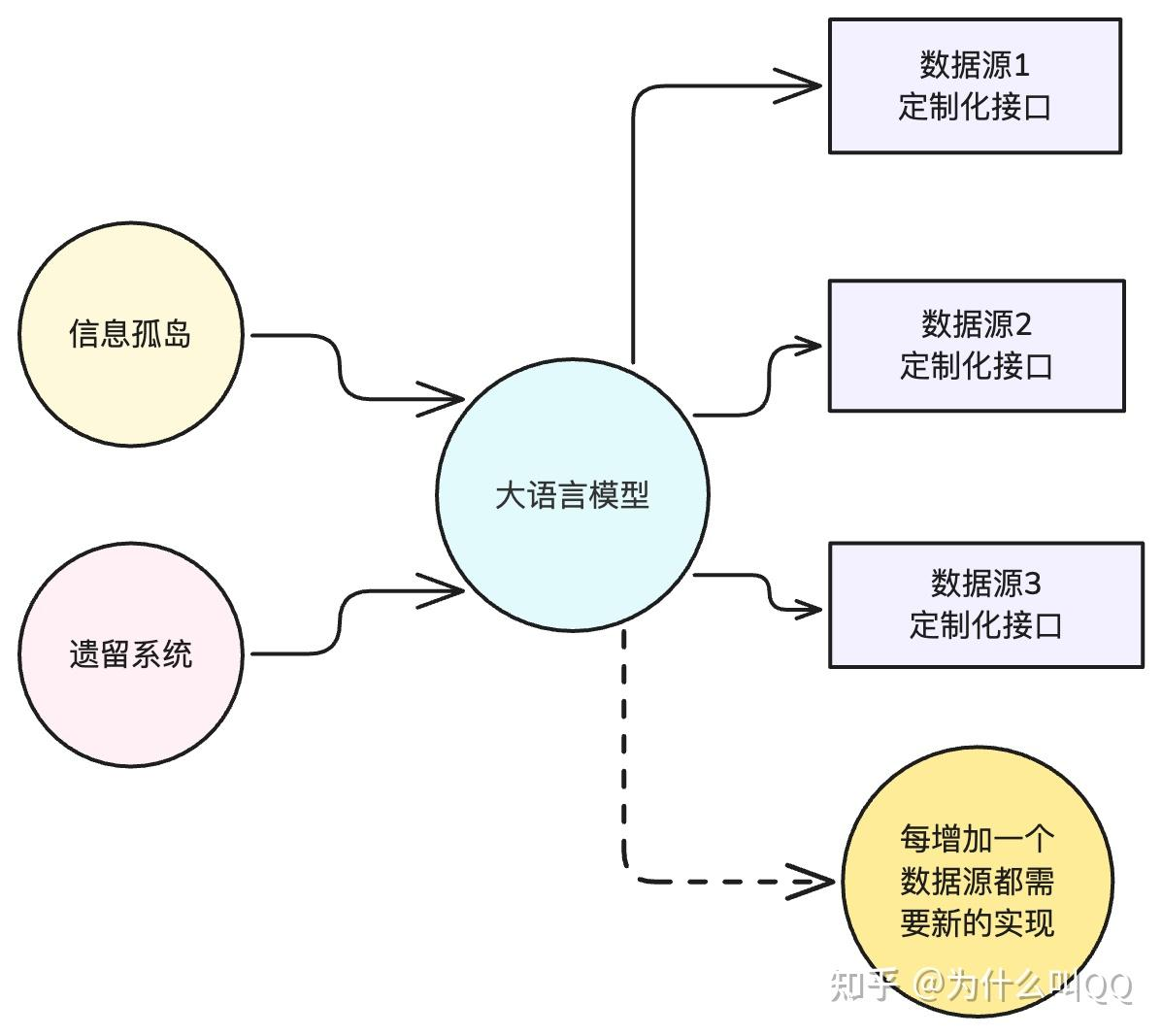

通用架构

MCP 的核心采用客户端-服务器架构,主机应用程序可以连接多个服务器:

- MCP 主机:像 Claude 桌面版、IDE 或希望通过 MCP 访问数据的 AI 工具

- MCP 客户端:通过 1:1 连接与服务器通信的协议客户端

- MCP 服务器:每个服务器都通过标准化的 MCP 协议暴露特定功能

- 本地数据源:您电脑中的文件、数据库和服务,MCP 服务器可以安全访问

- 远程服务:通过互联网可用的外部系统(如 API),MCP 服务器可以连接

开发资源

- 模型上下文协议规范和 SDK

- Claude Desktop 应用中对本地 MCP 服务器的支持

- MCP 服务器的开源仓库

Claude已经提供模型上下文协议规范和 SDK,可以在这个SDK基础上快速构建服务端和客户端,同时提供了 Google Drive、Slack、GitHub、Git、Postgres 和 Puppeteer 等常见企业系统的预构建 MCP 服务器。

开放的社区

MCP 是一个协作的、开源的项目和生态体系。无论 AI 工具的开发者、想要利用现有数据的企业,还是正处于探索前沿的早期采用者,都可以构建具有上下文感知能力的 AI 未来。